Не секрет, что для правильной seo-оптимизации необходим файл robots.txt, Это тот самый инструмент, который сообщает поисковым системам о параметрах индексирования сайта. В роботе Яндекса используется сессионный принцип работы, на каждую сессию формируется определенный пул страниц, которые планирует загрузить робот. Сессия начинается с загрузки файла robots.txt. Если файл отсутствует, не является текстовым или на запрос робота возвращается HTTP-статус отличный от 200 OK, робот считает, что доступ к документам не ограничен.

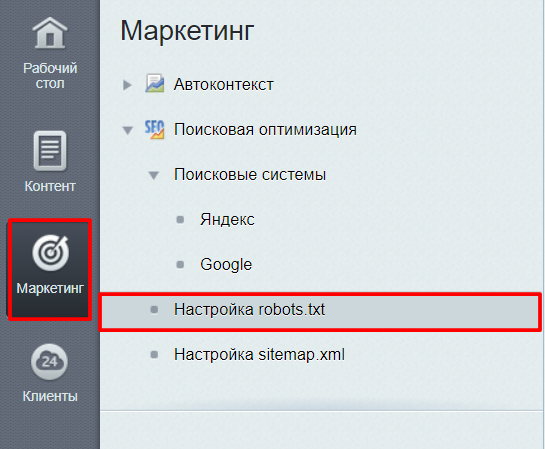

В битрикс robots.txt можно сформировать специальным инструментом по пути в системе администрирования: Маркетинг — Настройка robots.txt или по ссылке: /bitrix/admin/seo_robots.php.

Оптимальным набором параметров является:

|

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 36 37 38 39 40 41 42 43 44 45 46 47 48 49 50 51 52 53 54 55 56 57 58 59 60 61 62 63 64 65 66 67 68 69 |

User-agent: Yandex Disallow: /*index.php$ Disallow: /bitrix/ Disallow: /auth/ Disallow: /personal/ Disallow: */*search Disallow: /*/slide_show/ Disallow: /*/gallery/*order=* Disallow: /*print Disallow: /*register= Disallow: /*forgot_password= Disallow: /*change_password= Disallow: /*login= Disallow: /*logout= Disallow: /*auth= Disallow: /*?action= Disallow: /*action=ADD_TO_COMPARE_LIST Disallow: /*action=DELETE_FROM_COMPARE_LIST Disallow: /*action=ADD2BASKET Disallow: /*action=BUY Disallow: /*bitrix_*= Disallow: /*backurl=* Disallow: /*back_url* Disallow: /*COURSE_ID= Disallow: /*?COURSE_ID= Disallow: /*PAGEN_* Disallow: /*PAGE_NAME=user_post Disallow: /*PAGE_NAME=detail_slide_show Disallow: /*PAGE_NAME=search Disallow: /*PAGE_NAME=user_post Disallow: /*PAGE_NAME=detail_slide_show Disallow: /*SHOWALL Disallow: /*show_all= Host: example.com User-agent: * Disallow: /*index.php$ Disallow: /bitrix/ Disallow: /auth/ Disallow: /personal/ Disallow: */*search Disallow: /*/slide_show/ Disallow: /*/gallery/*order=* Disallow: /*print Disallow: /*register= Disallow: /*forgot_password= Disallow: /*change_password= Disallow: /*login= Disallow: /*logout= Disallow: /*auth= Disallow: /*?action= Disallow: /*action=ADD_TO_COMPARE_LIST Disallow: /*action=DELETE_FROM_COMPARE_LIST Disallow: /*action=ADD2BASKET Disallow: /*action=BUY Disallow: /*bitrix_*= Disallow: /*backurl=* Disallow: /*back_url* Disallow: /*COURSE_ID= Disallow: /*?COURSE_ID= Disallow: /*PAGEN_* Disallow: /*PAGE_NAME=user_post Disallow: /*PAGE_NAME=detail_slide_show Disallow: /*PAGE_NAME=search Disallow: /*PAGE_NAME=user_post Disallow: /*PAGE_NAME=detail_slide_show Disallow: /*SHOWALL Disallow: /*show_all= Sitemap: http://example.com/sitemap.xml |

Таким образом мы закрываем для индексации форму регистрации так и ряд страниц, т.к. они могут сформировать дубли страниц.

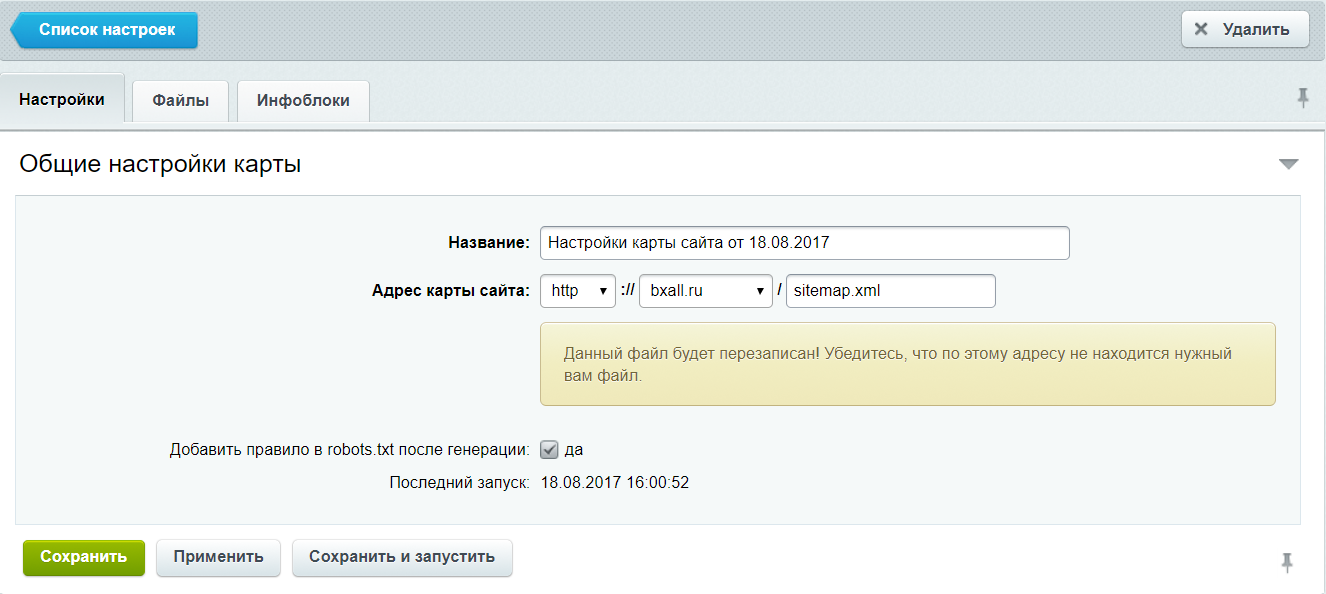

Вообще «robots txt» для битрикс формируется системой весьма корректно, единственно необходимо поправить его в соответствии с проектом, а по сути важные параметры система формирует сама, помимо этого буквально в 2 клика в настройках robots.txt можно удалить или наоборот добавить нужный параметр, а при создании sitemap ссылка в robots.txt формируется сама

Спасибо, полезный пост! Нужно ли закрывать /upload/ и открывать разрешения на подпапки?